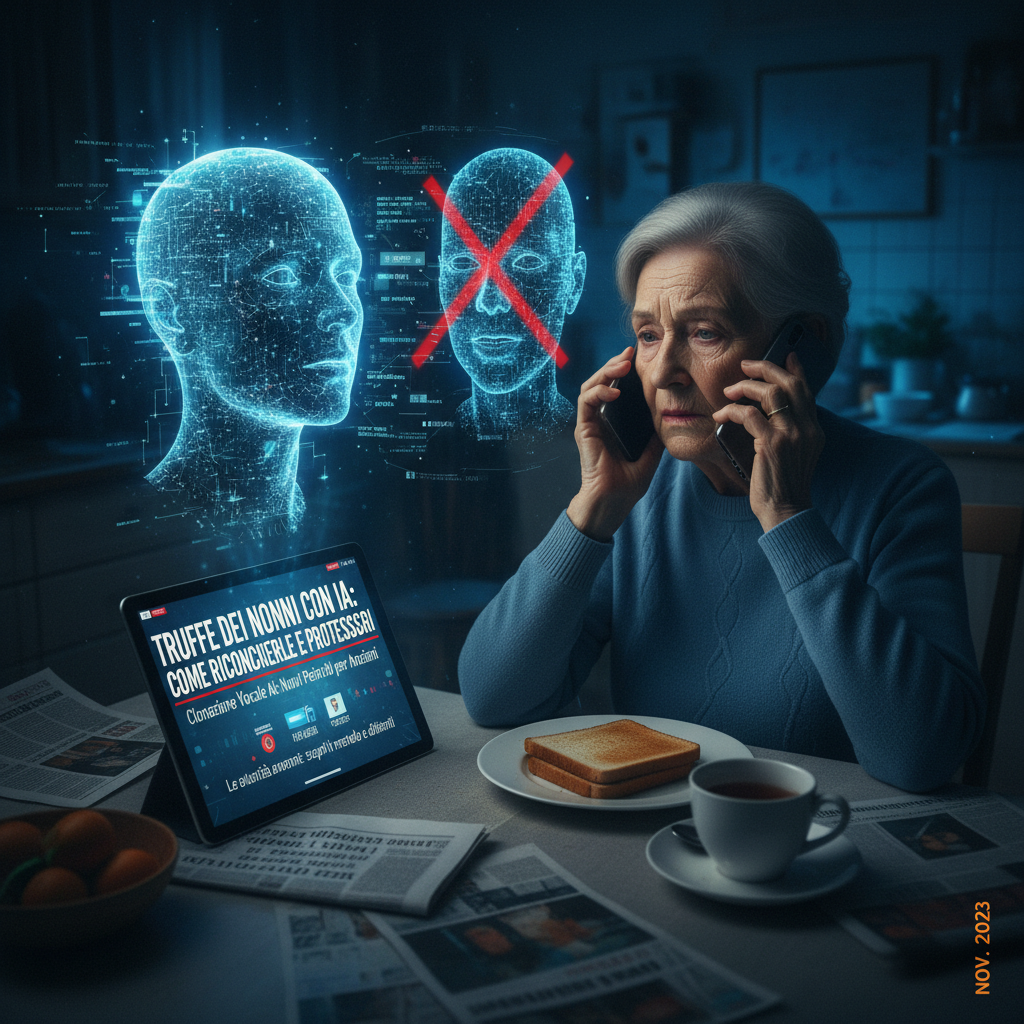

Truffe dei nonni con intelligenza artificiale: come riconoscerle e proteggersi

Immagina di ricevere una chiamata dal tuo nipote in preda al panico, che implora aiuto per un’emergenza improvvisa. La voce è identica, familiare, ma si tratta di una truffa sofisticata potenziata dall’intelligenza artificiale. La soluzione rapida? Verifica sempre con un’altra chiamata indipendente prima di agire: chiama il numero noto del familiare e conferma. Questo semplice passo salva migliaia di euro ogni anno.

Le truffe dei nonni sono frodi emotive che colpiscono principalmente gli anziani, fingendo emergenze familiari per estorcere denaro. Con l’avanzare della tecnologia, i malviventi usano l’AI per clonare voci, rendendo le chiamate indistinguibili dalla realtà. In Italia e nel mondo, i casi sono in aumento esponenziale, con perdite che superano i miliardi di euro.[1][2][5]

L’evoluzione delle truffe: dal telefono all’AI

Queste frodi non sono nuove, ma nel 2026 hanno raggiunto livelli allarmanti grazie all’intelligenza artificiale. I truffatori raccolgono informazioni dai social media – foto profilo, nomi di nipoti, dettagli personali – per personalizzare l’attacco. Una chiamata arriva di notte: “Nonno, ho avuto un incidente, ho bisogno di soldi subito per l’ospedale, non dire a nessuno!” La voce clonata, generata da pochi secondi di audio rubato online, crea panico immediato.[1][3][5]

In Italia, la Polizia Postale segnala un boom di casi nelle regioni del Nord e Centro, con vittime over 60 colpite nei momenti più vulnerabili: sere, notti, weekend. Globalmente, l’FBI nota un +30% di truffe telefoniche AI, mentre in Canada oltre 1.000 “rapimenti virtuali” hanno causato perdite medie tra 3.000 e 15.000 dollari per vittima.[5] Meta, proprietaria di Facebook e WhatsApp, ha introdotto tool AI per bloccare messaggi sospetti, ma la vera difesa resta la consapevolezza.[2]

Perché funzionano e chi sono le vittime

Queste truffe sfruttano l’urgenza emotiva: paura, panico, istinto protettivo. L’77% degli utenti non distingue una voce clonata da una reale, secondo studi recenti. Gli anziani, spesso meno familiari con la tecnologia, cadono più facilmente.[1][5] Non si tratta solo di nonni: chiunque con familiari giovani può essere preso di mira.

Reti organizzate, come quella smantellata dalla Guardia di Finanza di Brescia con 49 indagati (tra cui un cremonese), operano su più regioni – Toscana, Lombardia, Veneto – usando conti fittizi per riciclare i proventi. In quattro giorni, a Udine, tre arresti e 80.000 euro recuperati dimostrano l’impegno delle forze dell’ordine.[4][7][8]

Come difendersi: passi pratici e immediati

- Non agire d’impulso: Riaggancia e richiama dal numero ufficiale del familiare.

- Verifica l’identità: Chiedi dettagli solo tu conosci (un ricordo familiare privato).

- Non condividere dati: Mai codici, password o bonifici immediati.

- Segnala subito: Contatta Carabinieri (112), Polizia Postale o app come “Truffa Alert”.

- Educa i tuoi cari: Parla regolarmente di questi rischi, insegna a ignorare chiamate sconosciute.[1][2][3]

Se hai già pagato, agisci veloce: contatta la banca per bloccare bonifici, segnala a piattaforme come Zelle o Venmo. Campagne nazionali come quella di Confartigianato per il 2026 promuovono calendari con consigli quotidiani per prevenire rischi.[6]

Per gli over 60, Meta raccomanda: verifica autenticità dei contatti cercando numeri ufficiali autonomamente. Nessuna azienda legittima chiede dati via messaggio o chiamata non richiesta.[2]

Approfondimento tecnico: analisi della clonazione vocale

Come funziona la clonazione vocale con AI

La tecnologia si basa su modelli di sintesi vocale generativa, come Tacotron 2 o WaveNet, addestrati su dataset di audio. Con soli 3-30 secondi di voce (raccolti da video social o chiamate registrate), un’AI come ElevenLabs o Respeecher genera speech realistico. Il processo:

- Raccolta dati: Scraping da Instagram, TikTok per campioni vocali.

- Addestramento modello: Fine-tuning di reti neurali (es. Transformer-based TTS) per mimare timbro, accento, inflessioni.

- Generazione: Input di script (scritto dai truffatori) produce audio indistinguibile, con rumore di fondo per realismo.[1][5]

Statistiche tecniche: McAfee riporta che il 77% fallisce test di distinzione vocale. Latenza di generazione: <1 secondo su GPU consumer. Costo: tool gratuiti o $5/mese per cloni premium.

Contromisure tecniche avanzate

- App di rilevazione: Tool come Reality Defender o Pindrop analizzano anomalie spettrali (formanti vocali innaturali) con accuratezza >95%.

- Blockchain per verifica voce: Progetti come VoiceAuth usano hash vocali biometrici per autenticazione.

- AI difensiva: Meta impiega modelli predittivi su WhatsApp per flaggare pattern sospetti (chiamate brevi notturne da numeri esteri).[2]

Per esperti: implementa script Python con librerie librosa per analisi MFCC (Mel-Frequency Cepstral Coefficients), confrontando spettri vocali noti vs. sospetti:

import librosa

import numpy as np

def detect_clone(audio_file):

y, sr = librosa.load(audio_file)

mfccs = librosa.feature.mfcc(y=y, sr=sr, n_mfcc=13)

# Confronta con baseline familiare

anomaly_score = np.mean(np.abs(mfccs - known_mfccs))

return anomaly_score > threshold # Soglia empirica 0.5

Questo rileva discrepanze in armoniche tipiche di AI sintetici.[5]

Tendenze 2026 e prevenzione proattiva

Nel 2026, varianti includono rapimenti virtuali (“Hanno rapito tuo figlio, paga o lo senti urlare”) con audio clonati + effetti sonori. In Italia, finti operatori INPS via WhatsApp usano profili copiati da social.[3] Reti criminali evolvono con deepfake video su videochiamate.

Per tecnici: monitora API AI abuse con honeypot. Autorità come FBI raccomandano report aggregati per tracciare pattern. L’educazione resta chiave: integra workshop con simulazioni vocali.[1][5]

Proteggiti oggi: awareness + tecnologia = difesa invincibile. Condividi questo articolo con nonni e familiari.